点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

来源丨泡泡机器人SLAM

来源丨泡泡机器人SLAM

标题:DLL: Direct LIDAR Localization. A map-based localization approach for aerial robots

作者:Fernando Caballero and Luis Merino

来源:2021 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

编译:李雨昊

审核:柴毅,王靖淇

摘要

本文提出dll,一种直接基于历史地图的3D LiDAR定位方法。dll通过优化点云到历史点云地图的距离实现点云到地图的配准,而不通过特征计算和同名点对匹配。在给定初始位姿的情况下,本文方法基于里程计得到的位姿,并通过和地图的匹配更新位姿,实现机器人的位姿跟踪。通过在虚拟数据和真实数据集上的实验表明本文方法比基于蒙特卡洛定位的方法性能更优,比其他基于优化的方法速度更快,并对里程计位姿的初始位姿结果较为鲁棒。本文方法已开源:https://github.com/robotics-upo/dll。

作者借鉴NDT的思想(不对点云而是抽象化表达成其他形式),将历史点云地图表示成为3D距离场这种连续空间的表达(出去物体边缘和边界处),可以避免由于最邻近点搜索带来的计算瓶颈,同时这种高维拟合的表达对噪点较为不敏感,而且由于3D距离场的表达形式,使得在完成优化时梯度求解高效。并和基于ICP,NDT,蒙塔卡罗定位的方法进行了比较。

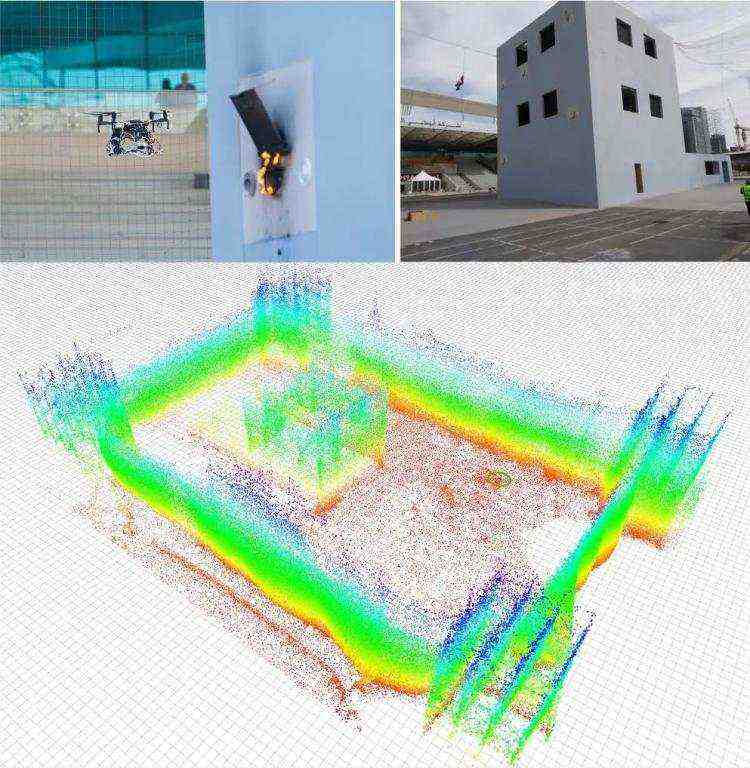

图1. MBZIRC20比赛中的场景,无人机用来灭火,基于历史点云地图完成配准。

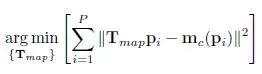

式1. 对于点云和点云地图的匹配问题,可以用该式子来表达:Tmap表示将点Pi变换到地图的变换矩阵,mc表示pi在点云地图中的对应同名点。通过优化上述非线性函数得到最优的位姿Tmap。其中涉及到两个问题,1)对应同名点如何获取;2)超定方程的求解。

式2. 为了减少KNN邻域点搜索带来的计算瓶颈,本文提出将点云地图表示为3D距离场,通过优化到点云地图中最近点的距离。历史地图的距离场可以离线事先构建好,而且只需要构建一次即可。

式3. 构建好的距离场存储在固定大小的格网中,每个格网中的距离场表示点云地图中最近点到该格网的距离,一旦构建好距离场,可以通过3维线性插值的方式得到该格网中任意位置点的距离场值。表达成距离场减少了对点云空间进行量化带来的梯度不稳定性,同时这种形式对于优化非常友好。

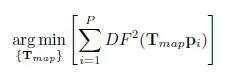

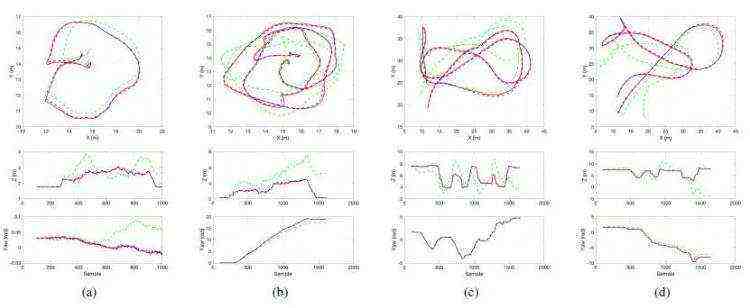

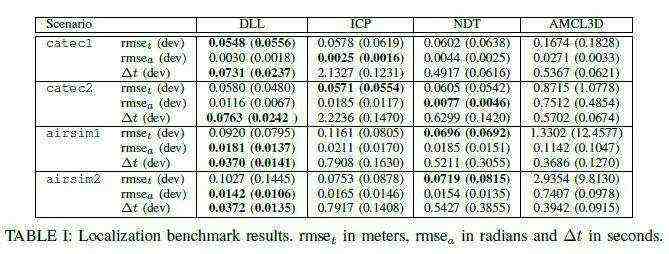

图2.Catec真实场景a、b,室内场景约15x15x5m和Airsim虚拟场景c、d室外场景约50x50x10m。

图3.轨迹真值(蓝虚线),dll估计轨迹(红实线)和里程计估计值(绿虚线)在四个实验数据上的结果对比。dll只估计了UAV的xyz和yaw角,row和pitch通过倾斜补偿认为是不需要优化的参数。

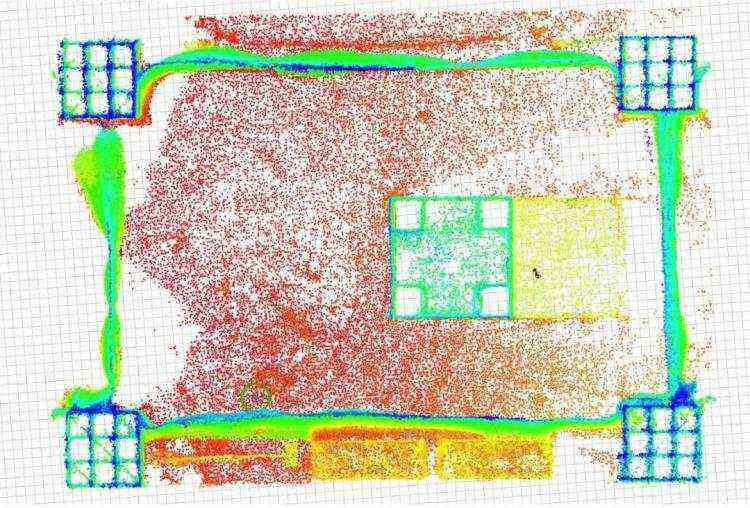

图4.MBZIRC2020比赛中的真实室外场景地图。

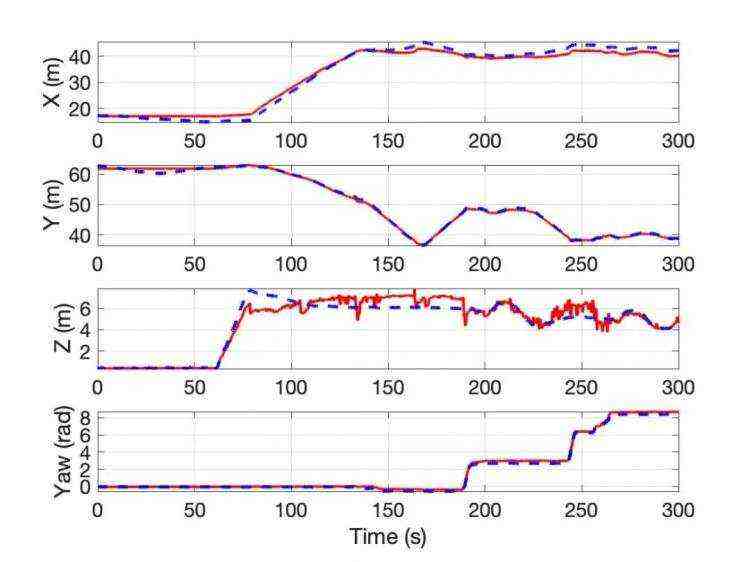

图5.MBZIRC2020数据集上估计的UAV位置。

Abstract

This paper presents DLL, a direct map-based localization technique using 3D LIDAR for its application to aerial robots. DLL implements a point cloud to map registration based on non-linear optimization of the distance of the points and the map, thus not requiring features, neither point correspondences. Given an initial pose, the method is able to track the pose of the robot by refining the predicted pose from odometry. Through benchmarks using real datasets and simulations, we show how the method performs much better than Monte-Carlo localization methods and achieves comparable precision to other optimization-based approaches but running one order of magnitude faster. The method is also robust under odometric errors. The approach has been implemented under the Robot Operating System (ROS), and it is publicly available.

本文仅做学术分享,如有侵权,请联系删文。

3D视觉精品课程推荐:

1.面向自动驾驶领域的多传感器数据融合技术

2.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)

3.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进

4.国内首个面向工业级实战的点云处理课程

5.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解

6.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦

7.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化

8.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM)

9.从零搭建一套结构光3D重建系统[理论+源码+实践]

10.单目深度估计方法:算法梳理与代码实现

11.自动驾驶中的深度学习模型部署实战

12.相机模型与标定(单目+双目+鱼眼)

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近4000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~